Проект 48 е кампания за медийна грамотност, вдъхновена от романа “1984”, която “Аз чета” и "Читалище.то“ стартират. “Аз чета” ще издаде книгата в луксозно издание и съвременен превод. 10% от отпечатания тираж ще бъде дарен на училищни библиотеки в страната, а с приходите от продажби на изданието ще се финансира поредица от срещи и уроци по медийна грамотност – в училища (за ученици) и библиотеки (за ученици и възрастни).

Uspelite.bg подкрепя Проект 48, защото медийната грамотност е кауза на всички нас, които вярваме, че създаването на една етична медийна среда у нас е възможно. За да се случи това обаче, всички ние заедно, медии и читатели, зрители, слушатели, трябва да обърнем по-голямо внимание на нещата, които се случват в медиите по света и у нас, да различаваме пропагандата и фалшивите новини и да НЕ разпространяваме непроверена или невярна информация със съмнителен произход. За тази цел ще препубликуваме материали от кампанията Проект 48, а как да я подкрепиш, може да видиш ТУК.

Днес ще ви запознаем с явлението дийпфейк (“deepfake” – англ.), чрез което се симулират видеоизказвания на публични личности, които всъщност никога не са се случили.

Кралица Елизабет танцува тик-ток танц по време на традиционното си коледно обръщение към британската нация, Барак Обама нарича Доналд Тръмп „пълно лайно“, Илън Мъск изпълнява популярната руска естрадна песен „Земля в иллюминаторе“, а Марк Зукърбърг се хвали с „тотален контрол над милиони присвоени лични данни“. Ако се замислим каква е вероятността тези събития да са се случили реално, ще се съгласим, че тя е нищожна, дори нулева. Но когато попаднем на подобно видео, споделено многократно в социалните мрежи, със сигурност поне в първите няколко минути ще изпитаме безпокойство или недоумение. Причината за това е, че макар и с абсурдно съдържание, тези видеа са с високо качество на изпълнение, което ги прави технически трудно различими от истинските.

Дийпфейк = „фотошоп“ в 21. век

Изправени пред плашещите възможности на новите технологии да подменят реалността, си спомняме едва ли не с умиление 90-те години. Тогава тепърва откривахме, че снимките на известни личности и фотомодели често са подложени на допълнителна обработка с цел да се прикрият недостатъци на фигурата или признаци на остаряване. Не само това – чрез най-популярния софтуер за редакция на цифрови изображения Adobe Photoshop, който навлезе разговорно в езика като „фотошоп“, можеха да се произвеждат сензации относно лица, които реално никога не са присъствали или участвали в ситуациите, в които уж са „заснети“.

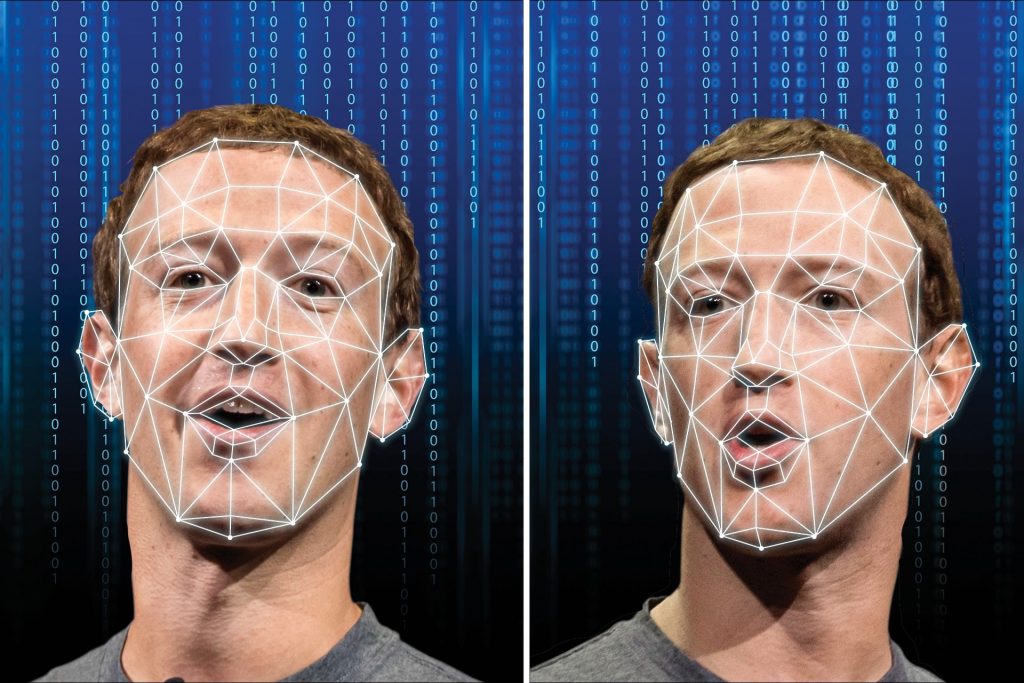

„Изучаване“ на лицевите движения (снимка: towardsdatascience.com)

Дийпфейк представляват ново поколение манипулации, при които с помощта на изкуствен интелект се комбинират кадри от реални събития и към тях се добавя ново съдържание. Най-често използваният метод е чрез размяна на лицата. Специализиран софтуер сравнява и изучава хиляди изображения на човека от реални видеа и неговия фалшив двойник, създава модели на лицата им и след това „блендира“ двата модела като наслагва израженията и мимиките на лицето „А“ върху лицето „Б“. Този процес се основава на deep learning – част от методите на машинно самообучение, а fake (англ.) означава „фалшификат“, затова явлението получава названието deepfake.

За първа употреба на дийпфейк се смятат порнографските видеоклипове, публикувани от потребител на мрежата Reddit през 2017 г., на които лицата на порно изпълнителите са заменени с тези на известни актриси.

Всеки ли може да произведе дийпфейк?

За да бъде манипулираното видео достатъчно убедително и заблуждаващо, то трябва да е с много добро качество. За постигането му са необходими професионални умения и мощни компютърни конфигурации от висок клас. Дийпфейк видеата с по-лошо качество се разкриват лесно чрез детайли като синхронизирането на устните, цвета на кожата, трептенето около очертанията на лицето. Но deepfake стават все по-достъпни чрез предлагането на такива услуги и дори приложения за обикновения потребител.

Отвъд видеоклиповете

Технологията на дийпфейк може да бъде използвана за подправяне на аудио чрез създаване на гласови „скинове“ или гласови „клонинги“ на публични личности. Чрез нея също могат да бъдат създавани убедителни, но напълно измислени „документални“ снимки като част от портфолиото на несъществуващи журналисти.

Друг начин за създаване на дийпфейк изображения е чрез т.нар. генеративна състезателна мрежа (generative adversarial network), или съкратено GAN. Чрез нея първоначално се създава „празно“ изображение, което се „захранва“ със стотици снимки на знаменитости, докато накрая, след многократна обработка на моделите на техните лица, се произвежда изключително реалистично „синтетично“ лице на несъществуваща знаменитост.

„Алтернативното“ Коледно обръщение на кралица Елизабет II:

Дийпфейк или не?

Технологията на дийпфейк се усъвършенства с бързи темпове и става все по-трудно да се различи фалшифицирано от реално видео. От своя страна, големи компании като Microsoft, Amazon и Facebook, но също и правителства, университети и технологични фирми инвестират средства в разработването на инструменти за засичане и разпознаване на дийпфейк.

През януари 2020 г., с оглед на предизборната кампания за президент на САЩ, Facebook обяви нова политика на забрана на манипулираните чрез изкуствен интелект дийпфейк видеа, които биха могли да заблудят потребителите, че някой е казал нещо, което в действителност не е. В същото време обаче, забраната не обхващаше видеоклипове със заблуждаващо и подвеждащо съдържание, направени с конвенционални технически средства.

Каква вреда могат да нанесат дийпфейк видеата?

Най-коварното последствие от разпространението на дийпфейк съдържание наред с фалшивите новини и други форми на синтетична медия е подкопаването на доверието на хората и изграждането на отровна медийна среда, в която вече трудно може да се различи истината от лъжата. В такова общество става лесно да се разпространяват всякакви слухове или да се повдигнат съмнения за неща, които реално са се случили.

Това размиване на границите между истината и лъжата дава удобна защита в ръцете на политиците. До неотдавна американският президент Доналд Тръмп наричаше всяка критика или нелицеприятна новина относно неговото управление „fake news“, съответно „fake media“ за телевизионния канал или вестник. Премиерът Бойко Борисов също прибягна до това оправдание, когато през юни 2020 г. в публичното пространство изтече запис на негов телефонен разговор.

Дяволът все пак не е толкова черен

Като всяка технология, дийпфейк технологията може да бъде вредна или полезна в зависимост от намеренията. Дийпфейк видеа на политици могат да бъдат използвани от сериозни медии с цел политическа сатира или за насочване на общественото внимание към проблема с дезинформацията. Такъв беше случаят с алтернативното коледно обръщение на кралица Елизабет по британския телевизионен канал Channel 4. То бе излъчено след официалното обръщение, а изказванията и поведението на мнимата кралица ясно показваха на зрителите, че става дума за комедийна пародия.

Коста Каракашян, дал лицето си назаем за филма „Добре дошли в Чечня“

Синтетичните лица и гласове се използват вече в рекламната индустрия, както и в строго секретни и високорискови операции на ниво държавно разузнаване например при установяване на контакт с терористични групировки. Дийпфейк технологията може да бъде приложена и в документални филми, за да бъде запазена анонимността на участниците и да не бъдат подложени на преследвания. Такъв е случаят например с филма на HBO „Добре дошли в Чечня“, който разказва за съдбите на ЛГБТИ хората там. Хората с различна сексуалност в Чечения са подложени на гонения, често пъти с опасност за живота им. По тази причина лицата и гласовете им във филма са дигитално модифицирани.

Дийпфейк e тук, за да останe

Не е учудващо, че в борбата с дийпфейковете най-ефективен е отново изкуственият интелект. Съществуващите системи за детекция на фалшиви видеа функционират най-добре, когато става дума за известни личности, тъй като могат да „тренират“ разпознаване върху свободно достъпни кадри. Други системи се основават върху разпознаване на оригиналния произход на медията, който може да се верифицира чрез дигитални защити или блокчейн технологии.

Дийпфейк технологията със сигурност няма скоро да излезе от употреба поради огромния си потенциал за иновации в различни сфери. С помощта на гласовото клониране можем да възкресим гласовете на хора, загубили говора си. Благодарение на нея ще имаме по-добър дублаж на игралните филми или ще можем да се насладим отново на играта на любим актьор в някой римейк години след смъртта му. Вероятно дийпфейк ще има приложения, които в момента все още звучат като сюжет от научна фантастика.

Най-сигурното средство за предпазване от дезинформация обаче ще си останат основните инструменти на медийната грамотност – критичното мислене и простичките правила за проверка на фактите.

Оригиналната публикация може да видиш ТУК. А предварителна поръчка на книгата „1984“ от Джордж Оруел с превода на Борислав Стефанов можете да направите в Хермес и Ozone.bg.